EINLEITUNG: GESCHICHTE

Probleme der Robotik

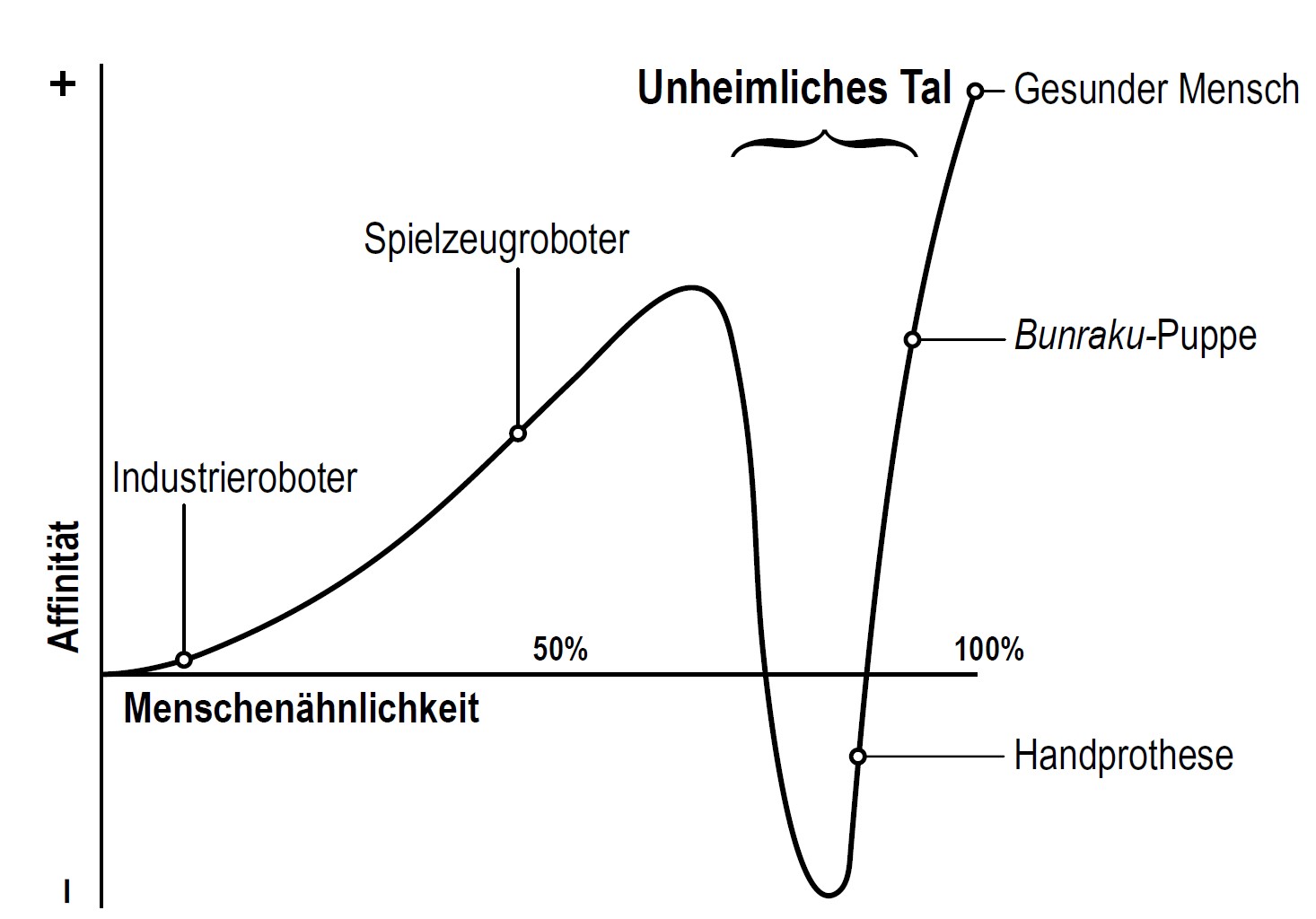

Die Erschaffung von künstlichen Lebewesen und humanoiden Robotern sind zwei Ziele in der Robotik. Im Jahr 1970 hat der Ingenieur Masahiro Mori einen Graphen aufgestellt, der die emotionale Verbindung von Menschen zu menschenähnlichen oder anthropomorphen Androiden darstellt (vgl. Abb. 1). Der Graph verhält sich wie eine ansteigende Kurve, die aber in ein Tal ausbricht, bevor Sie ihren Extrempunkt bei der 100-prozentigen Menschenähnlichkeit erreicht. Diese Schlucht wird von Mori als das „Unheimliche Tal“ bezeichnet. Das auch allgemein als Uncanny Valley bekannte Phänomen beschreibt ein unangenehmes Gefühl, welches auftritt, sobald wir eine Darstellung eines beinahe gesunden Menschen sehen. Ein gutes Beispiel hierfür sind Arm- oder Beinprothesen, die deutlich erkennbar sind. Obwohl die Prothetik in diesen Bereichen große Fortschritte gemacht hat, löst die Erkenntnis einer Prothese bei den meisten Menschen ein unangenehmes Gefühl aus (MORI et al., 2019).

Abb. 1: Der Uncanny Valley Graph von Masahiro Mori

(MORI et al., 2019)

Beginn von Computergrafiken

Die Anfänge der Computergrafik liegen in den frühen 1950er-Jahren. Damals wurde die Technik verwendet, um Radardaten der amerikanischen „Air Force“ in Computerinformationen zu übersetzen. Mithilfe eines „Lichtstiftes“ wurde hier mit einem Display interagiert (MACHOVER, Carl, 1994, S. 14-19).

Ende der 60er-Jahre wurden Technologien entwickelt, die auch in der gegenwärtigen Zeit noch ihren Nutzen finden. Der Scanline-Algorithmus war einer der ersten Renderingmethoden, wie wir sie heute kennen. Dabei werden alle Informationen in der virtuellen Szene gesammelt und auf ein 2-dimensionales Bild projiziert. Die Z-Achse des Renderbildes gibt in der Projektion den Abstand zur Kamera wieder. So können Objekte von Hinter- und Vordergrund unterschieden werden. Dieser gesamte Prozess wird Rasterisierung genannt (DINUR, 2021). Auch heutzutage wird dieser noch eingesetzt. Ein bekanntes Beispiel davon ist Blenders Eevee Echtzeitrenderengine (Blender Foundation, 2019).

Für Forschungs- oder Simulationszwecke können realistische Grafiken sehr hilfreich sein. Deshalb konnte man schon früh absehen, dass Fotorealismus ein wichtiges Ziel von Computergrafiken ist. Ein weiterer Grund dafür sind die Produktionskosten. Visualisierungen lassen sich virtuell günstiger erstellen als echte Prototypen (Foley et al., 1990, S.605-648). Das große Problem bei der realistischen Darstellung von Objekten ist die Komplexität der echten Welt. Den Detailreichtum der unterschiedlichen Größenordnungen aus der Realität nachzustellen ist sehr schwierig. Im virtuellen Raum müssen Gegenstände auf Polygone reduziert werden. Die Anzahl dieser Vielecke in einer Szene bestimmt die benötigte Rechenleistung. Um effizienter mit der damals verfügbaren Leistung umzugehen, wurde die Rasterisierungsmethode in mehrfachen Iterationen eingesetzt. Dabei wurden Linien, Farbflächen, Texturen (Maps), Lichter, Schatten und Displacement nacheinander in mehreren Durchgängen berechnet. Danach wurde alles zu einem Ergebnis zusammengeführt (Foley et al., 1990, S.605-648).

Zu einer ähnlichen Zeit wurden bereits die ersten Raytracing Ansätze entwickelt. Es handelt sich um eine physikalisch korrekte Rechenmethode, die Lichtstrahlen von ihren Quellen aus berechnet. Jeder Strahl (Ray) wird, sobald dieser auf ein Objekt trifft, akkurat reflektiert oder gebrochen und weitergeleitet. Das geschieht so lange, bis das Auge, im Fall der Computergrafik die simulierte Kamera, getroffen wird. Das erzeugt eine korrekte Darstellung der realen Lichtverhältnisse in einer virtuellen Szenerie (PARKER et al., 2010, S.1-13). Diese Methode liefert genauere Ergebnisse als Scanline-Algorithmen, ist dafür aber wesentlich langsamer.